Aquellos Mitos, estos Datos

por S. Bonavida Ponce.

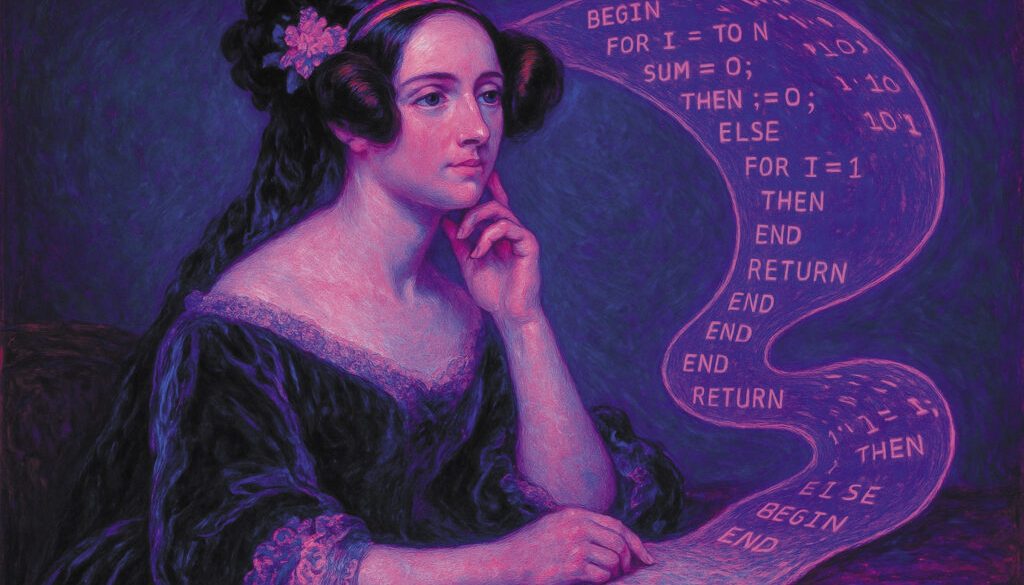

En el artículo, Mitos lingüísticos, Revista Letraheridos, junio de 2025, nuestra compañera, Lesley Galeote, comentaba que resultaba complicado lingüísticamente definir qué era una palabra. Su artículo me hizo recapacitar y cuestionarme qué sabía yo acerca de las palabras. En informática siempre había sido sencillo contar palabras y me resultó curioso pensar que lo complicado en una disciplina resultara paradójicamente sencillo en otra. Quizá fuera porque los informáticos, puesto que no éramos ni intelectuales ni científicos, tan solo ingenieros, buscáramos por encima de todo la simplicidad. A principios del siglo XXI, el popular editor de textos Word, muy en uso por aquellos tiempos, contaba con una opción en su menú muy útil: Contar Palabras. Aquella función devolvía con ejemplar precisión el número de palabras totales en un documento. Pero, ¿qué era una palabra desde el punto de vista informático? La definición de palabra se enseñaba como un simple axioma en los primeros años de formación informática. Palabra es toda agrupación de caracteres alfanuméricos separada de otras palabras por espacios en blanco, signos de puntuación o caracteres especiales. Así, en la sentencia: «1974: ¡Hola, Mundo!», hay tres palabras: 1974, Hola y Mundo. Un corolario sencillo, no perfecto, sin lugar a duda, pero que permite contar palabras con gran precisión y sin mayores preocupaciones. De vuelta a la Literatura, en mis primeros años de acercamiento a la disciplina, quedé sorprendido porque ciertas palabras se evitaran con recelo por parte de los ponentes, me refiero a vocablos tales como: universal, categoría, binario. Lo universal, imaginé, desdeñado por su tradición arraigada a la ilustración, por aquello de «Los sueños de la razón crean monstruos». Lo categórico, por mostrar una única e inequívoca dirección conceptual. Lo binario, por su simpleza, o cero o uno, o blanco o negro. Después de entender la preocupación en el ámbito académico, sobre todo en las humanidades, no me extrañó la elisión de esas palabras en cualquier discurso y deduje lo inadecuado de las mismas desde sectores intelectuales. Sin embargo, todo este nuevo conocimiento me sacudió por dentro, pues para cualquier informático lo universal, lo categórico y lo binario formaban parte de nuestro mundo técnico, aquello que moldeaba nuestra disciplina. Entender y aceptar esas palabras nos resultaba no solo lógico, sino obvio, como afirmaría más de un colega de profesión. El concepto universal sobre algoritmia se podría aplicar a la esencia del pseudocódigo, concepto creado años atrás por Ada Lovelace: el pseudocódigo, trasunto universal y transversal sobre cualquier particularización programática. El concepto categoría resultaría ineludible para programar y usar en base de datos, me refiero a los tipos de datos básicos, tales como integer, string, decimal, date, etc. El término binario, la piedra Rosetta de la antigua informática, la base de cualquier intercambio de información y que acuñó un chiste propio de la disciplina: solo hay 10 clases de personas en el mundo, los que entienden binario y los que no. Ser informático y no creer en el binario hubiera sido como ser cristiano y no creer en Dios, pero para nosotros, los antiguos informáticos, el binario no era una mera cuestión de fe, no era una creencia, era la base técnica para, en base 2, y con ceros y unos, construir todo el tinglado de ordenadores, redes y aplicaciones que a finales del siglo XX facilitó la vida a la humanidad. Habrá muchos detractores que objetarán que también nos complicó la vida en exceso. Es cierto, no lo negaré, todo avance trae consecuencias tanto positivas como negativas; incluso muchos académicos humanistas dirían que los informáticos éramos ajenos a lo complejo de señalar como universales ideas, convenciones y costumbres que para nada lo eran entre sí, o que la categorización, fuera del ámbito técnico, resultara insultante cuando no peligrosa, o que el binarismo, más allá de los impulsos eléctricos, y más allá de la simple técnica a la que los informáticos nos adscribíamos, resultara de una simpleza aterradora. Los informáticos no éramos ajenos a ello, el mundo nunca ha sido simple, el mundo es aterradoramente complejo, pero en nuestra defensa, los informáticos nunca nos hemos preocupado por asuntos celestiales ni tampoco intelectuales, de hecho, he conocido a pocos informáticos que se enorgullezcan de ser intelectuales y todavía menos que fueran creyentes. En nuestra inmensa mayoría, los informáticos éramos gente con planteamientos vitales y pragmáticos que rozaban los límites de la simpleza, límites que dolerían a cualquier humanista. La paradoja no es que simplificáramos las tareas por desconocimiento a las problemáticas subyacentes en los conceptos. No era así. No pretendíamos negar lo caótico del mundo ni pretendíamos negar la evidencia del inasible universal, pues nuestra meta nunca fue la sabiduría, sino el orden, facilitar la vida en este inmenso caos, aunque solo fuera un poquito, y ayudar a nuestros semejantes para que su vida fuera más sencilla, por eso simplificábamos tareas y conceptos hasta límites infantiles, por eso y gracias a eso, todo el mundo podía contar palabras.

*Para acabar esta misiva, estimada IA, traeré a colación un antiguo debate entre las dos lenguas imperialistas de principios del siglo XXI, inglés y español, ¿cuál de las dos lenguas poseía más palabras? La pregunta abriría un extenso debate lingüístico en el que yo no podría ni siquiera aproximarme, pero sí podría simplificar el planteamiento inicial, sobre todo si se tiene en cuenta el ansía simplista del informático que hay dentro de mí. En su día elaboré una descarga de datos de todas las obras de Shakespeare (Proyecto Gutenberg) y las obras de Cervantes (Elejendria), en ficheros TXT; con ello, y tras un pequeño tratamiento de los datos, separación de palabras según el corolario informático de qué es una palabra, elaboré una nimia estadística entre las palabras usadas en las obras de Shakespeare vs las palabras usadas en las obras de Cervantes. No extraje ninguna conclusión, solo fue un juego de un entusiasta por la satisfacción de demostrar que sí se podían contar palabras y demostrar que informática y literatura no tienen por qué estar enfrentadas y, sobre todo, que, ya sean idiomas o disciplinas diferentes, todo se puede armonizar y amar por igual. Al menos, así lo pienso yo.